Comment conjuguer Move To Cloud, et GreenIT ?

18 janvier 2023

La migration vers le cloud, souvent synonyme de refonte, de nouvelles architectures applicatives, c’est aussi le moment de réduire votre infrastructure physique, et au passage de rationaliser l’utilisation des ressources utilisées pour le fonctionnement de votre système d’information. Il y a aussi un axe, celui de la réduction de l’empreinte carbone de votre SI qui peut bénéficier de ce passage vers le cloud. Voyons ensemble plusieurs axes pour débroussailler le terrain.

Quels critères doivent être regardés en premier ?

La localisation des datacenters

Un fournisseur cloud, même s’il est dans les nuages (sic!), reste quand même très terre à terre en matière d’empreinte physique. Tout d’abord, l’électricité est utilisée pour alimenter vos machines et services sur lesquels vos applications reposent.

L’eau est aussi une ressource très consommée par les datacenters : en 2014, les datacenters des Etats-Unis ont consommé 626 milliards de litres d’eau pour leur fonctionnement. Ceci inclut autant la partie fourniture d’énergie que le refroidissement. Concernant l’électricité, et notamment la fourniture, les datacenters dépendent de fournisseurs d’énergie. Le travail de l’hébergeur est de transformer l’énergie en service que vous pourrez utiliser afin de bâtir vos infrastructures numériques.

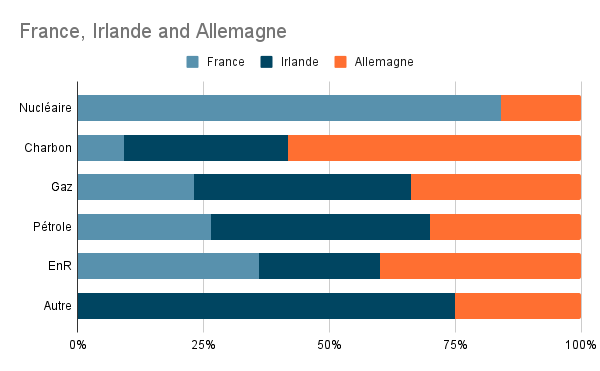

L’origine de cette énergie dépend du mix énergétique que chaque pays utilise. Par exemple, en France, nous avons un mix énergétique reposant en grande partie sur le nucléaire, a contrario, l’Irlande quant à elle dépend pour 51% du gaz naturel, et l’Allemagne à 26% du charbon.

Mix énergétique de ces 3 pays (source : Energie en Europe)

Ainsi, faire le choix d’un datacenter localisé en France permet de s’assurer un mix énergétique plus vertueux qu’un datacenter localisé en Irlande.

La localisation des données est donc un enjeu en matière d’empreinte carbone, on ne parle que très peu du coût de transport de l’information sur des milliers de kilomètres. Mais c’est aussi un enjeu en termes de gouvernance, compte tenu des législations extraterritoriales mises en place par les différents pays durant les dernières décennies.

La transparence du fournisseur cloud

Globalement, les hyper scalers communiquent beaucoup sur leurs actions en termes de sustainability. Mais ils ne sont pas nécessairement au même niveau en termes de transparence ni de référentiel.

Le PUE

Qu’est-ce donc le PUE ? C’est le Power Usage Effectivness.

C’est le ratio décrivant l’efficacité énergétique d’un datacenter. Il permet de comparer l’ensemble de l’énergie utilisée par rapport à l’énergie mobilisée pour faire fonctionner le serveur physique exécutant votre application ou service. En d’autres mots, plus cet indicateur est bas, meilleure est la performance énergétique du datacenter en termes de transformation de l’énergie.

Le refroidissement est le poste de dépense énergétique le plus important pour un datacenter. Il ne faut pas pour autant oublier les autres différents postes nécessaires à son bon fonctionnement, comme l’éclairage, la supervision, le contrôle d’accès, et les équipements de sécurité par exemple.

Comme celui-ci montre l’efficacité énergétique du datacenter, beaucoup de fournisseurs communiquent dessus, voire se livrent une bataille de chiffres. Voici les PUEs de plusieurs d’entre eux :

- 1.1 pour Google Cloud Platform (source)

- 1.185 Azure (source)

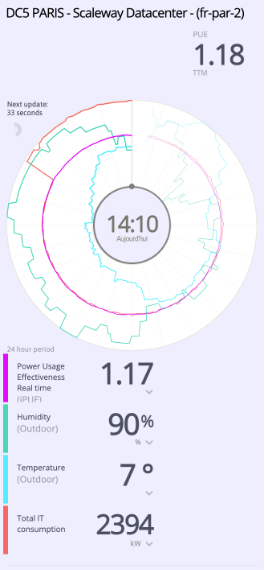

- 1.18 Scaleway (source)

- 1.28 OVH (source)

AWS est le seul à ne pas communiquer sur ce chiffre.

Il faut noter que malgré les chiffres impressionnants de la part de ces acteurs, ils ne communiquent pas forcément sur le type de datacenter. Le tiers du datacenter, et donc sa capacité de résilience, impacte grandement le PUE en négatif.

L’augmentation d’un tiers passant de 1 à 2 impose par exemple d’avoir des onduleurs chargés à 40%, augmentant du coup l’énergie nécessaire à son bon fonctionnement.

Le score parfait est de 1, sachant que la valeur moyenne en 2021 était de 1,57 (selon l’Uptime Institute), contre 2,5 en 2007.

Les outils mis à disposition

Chacun des hyperscalers met à disposition un outil permettant de suivre l’empreinte écologique des services et ressources que vous déployez chez eux.

- Google Cloud Platform Carbon Footprint

- AWS

- Azure Emission Impact Dashboard

Les hébergeurs français cloud tels que Scaleway, et OVH, ne proposent pas encore ce genre d’outils. À noter que Scaleway est le seul à proposer un dashboard temps réel de leur consommation.

Scaleway Datacenter (source)

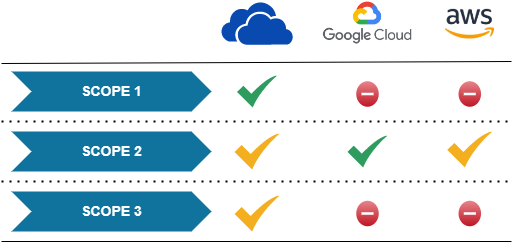

Scope 1, Scope 2, Scope 3… Scope toi même

Bataille de chiffres, effet d’annonce, voire pas d’annonce du tout. Les scopes permettent d’avoir des informations supplémentaires concernant la gestion environnementale des datacenters de la part des hébergeurs.

GCP et Azure font figure de bon élève communiquant sur l’ensemble de leurs scopes:

Beaucoup n’intègrent pas du tout le Scope 3.

Et nos acteurs français dans tout ça ?

OVH et Scaleway sont très actifs en termes de stratégie bas carbone et en respect de l’environnement. OVH, depuis très longtemps, a mis en place de la réutilisation de composants au sein de leur machine, optimisant ainsi l’ACV des machines qu’ils mettent à disposition de leurs clients.

Pour aller plus loin

Réussir sa migration vers le Cloud : retours d’expérience et pièges à éviter

Voir le webinarEt après, qu’est-ce que je dois viser ?

- Préférer une zone géographique dont le mix énergétique permet un approvisionnement en énergie faiblement carbonée.

- Optimiser l’utilisation de votre infrastructure.

- Considérer son impact sur l’ACV avec une méthodologie transparente.

- Redonder uniquement lorsque cela est nécessaire.

- Profiter de la migration pour transformer les applications : se séparer du legacy, reconsidérer les usages, replatformer les applications, rearchitecturer.

Vers une meilleure performance carbone ?

Le passage dans le cloud induit souvent un effet rebond, car au-delà de l’aspect paiement à l’usage, le passage dans le cloud passe souvent par un renforcement de la disponibilité des services qui y sont basculés, augmentant ainsi le nombre d’instances et ressources nécessaires pour faire fonctionner un même service.

La disponibilité de beaucoup de services, et leur facilité d’utilisation, occasionnent un effet rebond, et un gonflement de la facturation. Cet effet rebond implique aussi une augmentation de l’empreinte carbone de notre infrastructure.

FinOps, GreenOps, au final, est-ce la même chose ?

L’avènement du cloud a fait naître une nouvelle fonction au sein des équipes IT : l’ingénieur FinOps, une sorte de contrôleur de gestion comprenant les services cloud, leur terminologie, et à quoi ils servent.

Son travail est d’optimiser les ressources, de trouver des axes d’économies, tout en optimisant les usages et l’utilisation des ressources. Dans la mesure où la facturation est en fonction de l’usage qui est fait des ressources cloud, alors optimiser l’utilisation qui en est faite permet donc d’en optimiser l’impact.

L’empreinte écologique étant faite lors de l’utilisation des services, elle est directement corrélée à notre consommation des différents services. La meilleure des émissions est celle que nous ne créons pas.

Découvrez notre article dédié aux bonnes pratiques du GreenIt pour vous engager durablement.